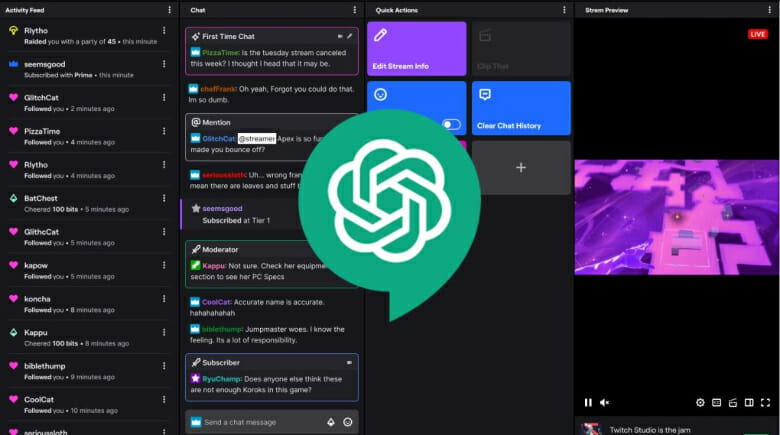

ChatGPT كوسيط: الذكاء الاصطناعي ينظم الشبكات الاجتماعية ومنصات البث؟

ربما يتولى الذكاء الاصطناعي دورًا جديدًا: دور الوسيط على المنصات. مع قيادة GPT-4 للمشروع ، فإنها تسعى إلى مكافحة المحتوى الضار عبر الإنترنت وتبسيط الامتثال لسياسات النظام الأساسي.

قد يكون GPT-4 ، نموذج اللغة الكبيرة القوي المستند إلى AI (LLM) خلف ChatGPT Plus – النسخة المدفوعة من ChatGPT – في طريقه إلى أخذ دور جديد حاسم كمشرف على الإنترنت ، ومراقبة المنتديات والشبكات الاجتماعية للمحتوى الضار.

ينبع هذا المنظور من منشور مدونة حديث بواسطة OpenAI ، الشركة التي تقف وراء روبوت المحادثة هذا ، والذي يشير إلى أن هذه الخطوة يمكن أن تمنح الجميع أداة رائعة لتحسين رؤية منصات مثل Facebook أو حتى Twitch.

يوضح موقع OpenAI على مدونته أن “الإشراف على المحتوى يلعب دورًا مهمًا في الحفاظ على سلامة الأنظمة الأساسية الرقمية. ينتج عن نظام الإشراف على المحتوى الذي يستخدم GPT-4 تكرارًا أسرع لتغييرات السياسة ، مما يقلل من وقت الدورة من أشهر إلى ساعات”.

“تقليديًا ، يقع عبء هذه المهمة على عاتق المشرفين البشريين الذين يقومون بتصفية كميات كبيرة من المحتوى لتصفية المواد الضارة والسامة ، مدعومة بنماذج تعلم آلي أصغر محددة الرأسية. العملية بطيئة بطبيعتها ويمكن أن تكون مرهقة عقليًا. في الوسطاء البشريين ،” ويضيفون.

إدارة ChatGPT للشبكات الاجتماعية؟ وداعا لوظيفة الإنسان؟

وفقًا لـ OpenAI ، فإن التركيز على الذكاء الاصطناعي كمشرف له العديد من المزايا. من ناحية، يمكن أن يسمح استخدام GPT-4 باتخاذ إجراءات أسرع بشأن تغييرات السياسة ، مما يقلل الوقت اللازم من شهور إلى ساعات.

علاوة على ذلك ، يمكن للذكاء الاصطناعي هذا فهم وتطبيق القواعد والفروق الدقيقة لتوثيق السياسة في مثل هذه المناسبات الواسعة ، والتكيف على الفور مع التحديثات ، مما يؤدي إلى الكمال للغاية وقبل كل شيء الاعتدال الدقيق.

لتوضيح هذا المفهوم ، يقدم منشور مدونة OpenAI مثالاً. قد تقوم فرق الإشراف بتعيين علامات لمحتوى معين للإشارة إلى ما إذا كان يتوافق مع قواعد النظام الأساسي. يمكن لـ GPT-4 تطبيق الملصقات بمفردها من نفس مجموعة البيانات ، دون معرفة الردود السابقة. يمكن للمشرفين البشريين بعد ذلك مقارنة مجموعتي الملصقات ، والاستفادة من التناقضات لتحسين وضوح القواعد.

على الرغم من الفوائد المحتملة ، تظهر بعض الأسئلة والمشاكل على طول الطريق. صحيح أن الاعتدال الحالي في أيدي البشر ، الذين يتعرضون لمحتوى هائل يجب عليهم تعديله. يمكن أن يؤدي إدخال الذكاء الاصطناعي في هذه الميزة إلى تحسين ظروف العمل للمشرفين البشريين وتخفيف عبء الدماغ الذي يأتي مع التحكم في كل هذا المحتوى.

ومع ذلك ، هناك نفس المشكلة القديمة الكبيرة في الذكاء الاصطناعي: فقدان الوظائف في هذه العملية. إذا حلت GPT-4 محل الوسطاء البشريين ، فإنها ستثير بلا شك مخاوف بشأن فقدان الوظيفة بدلاً من إعادة التعيين في أدوار أخرى.

على الرغم من أن OpenAI لا تتناول هذه المشكلة صراحة في منشوراتها ، مما يثير تساؤلات حول ما إذا كانت الشركات الكبيرة ستعتمد الذكاء الاصطناعي فقط كإجراء لتوفير التكاليف ، إنها تترك رسالة ذات صلة في النهاية.

“كما هو الحال مع أي تطبيق للذكاء الاصطناعي ، يجب مراقبة النتائج والمخرجات بعناية والتحقق من صحتها وصقلها من خلال إبقاء البشر في الحلقة. ومن خلال تقليل المشاركة البشرية في بعض أجزاء عملية الاعتدال التي يمكن التعامل معها بواسطة نماذج اللغة ، يمكن للموارد البشرية التركيز بشكل أكبر على معالجة الحالات المتطورة المعقدة التي تمس الحاجة إليها لتنقيح السياسة “.

على الرغم من أوجه عدم اليقين ، فإن فكرة استخدام الذكاء الاصطناعي لتقليل العمل الشاق للوسطاء وتحسين أمان المنصات الرقمية هي فكرة غريبة للغاية ، على الأقل في الوقت الحالي.

حيث يندمج تدريجياً في بعض المنصات سيكون من المثير للاهتمام أن نرى كيف يعمل الذكاء الاصطناعي بالفعل في هذه الحالة وما إذا كان غياب الإنسان كارثيًا للغاية في هذه الحالة حيث تكون الفروق الدقيقة وسياق اللغة مهمًا حقًا لمعرفة ما إذا كان يجب على الشخص مغادرة محادثة النظام الأساسي أم لا.